随着互联网技术的飞速发展,实时热点已经成为人们获取信息的重要途径之一,在编程领域,如何利用代码捕捉往年12月27日的实时热点,对于开发者而言具有一定的挑战性和实用性,本文将介绍如何使用代码制作往年12月27日的实时热点,帮助开发者快速获取热点信息,提高信息获取效率。

数据收集

要获取往年12月27日的实时热点数据,可以通过以下几种途径:

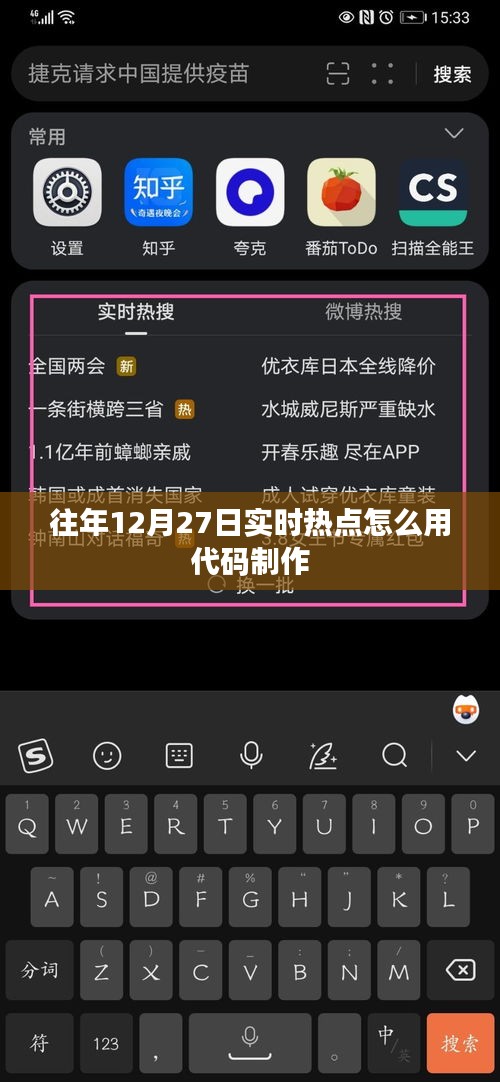

1、使用爬虫技术从各大新闻网站、社交媒体平台等获取相关热点信息。

2、通过API接口获取实时数据,如微博热搜、知乎热搜等。

3、从已有的数据库或数据集中提取相关历史数据。

在数据收集过程中,需要注意数据的准确性和时效性,对于爬虫技术,需要遵守相关网站的爬虫协议,避免侵犯版权或被封IP,对于API接口,需要获取合法的API密钥或授权。

数据分析与整理

收集到数据后,需要进行数据分析和整理,可以使用Python等编程语言进行处理,具体步骤如下:

1、数据清洗:去除无效、重复、错误数据,保证数据的准确性。

2、数据提取:提取关键信息,如标题、链接、发布时间等。

3、数据分类:根据热点主题进行分类,如娱乐、科技、政治等。

4、数据排序:根据热度或其他指标对热点进行排序,以便后续展示。

实时热点展示

完成数据分析和整理后,可以将实时热点以可视化的方式展示给用户,可以使用Web开发技术(如HTML、CSS、JavaScript)构建一个网页来展示实时热点,也可以使用其他工具(如桌面应用程序、移动应用程序等)进行展示,展示方式可以根据实际需求进行选择和设计。

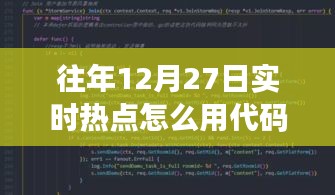

代码实现示例

下面是一个简单的Python代码示例,用于从某新闻网站获取往年12月27日的实时新闻数据并进行展示:

import requests

from bs4 import BeautifulSoup

import datetime

import pandas as pd

设置目标网站URL和API密钥(如有需要)

URL = "目标网站URL"

API_KEY = "API密钥(如有需要)"

获取往年12月27日的新闻数据

def get_news_data():

response = requests.get(URL)

soup = BeautifulSoup(response.text, 'html.parser')

news_list = soup.find_all('div', class_='news_item') # 根据实际页面结构进行修改

return news_list

解析新闻数据并提取关键信息

def parse_news_data(news_list):

news_data = []

for news in news_list:

title = news.find('h2').text # 新闻标题

link = news.find('a').get('href') # 新闻链接

publish_time = news.find('span', class_='publish_time').text # 发布时间

news_data.append({'Title': title, 'Link': link, 'Publish Time': publish_time})

return pd.DataFrame(news_data) # 将新闻数据转换为DataFrame格式方便后续处理和分析展示等操作,可以根据实际需求进行修改和扩展,这里只是一个简单的示例代码,实际开发中需要根据具体情况进行调整和优化,同时还需要注意遵守相关法律法规和网站的使用协议避免出现侵权等问题,此外还需要对获取的数据进行清洗去重排序等操作以满足实际需求,最后通过Web开发技术或其他工具将实时热点可视化展示给用户以便快速获取热点信息提高信息获取效率。转载请注明来自杭州天轩图文设计有限公司,本文标题:《如何编写代码追踪往年12月27日实时热点》

百度分享代码,如果开启HTTPS请参考李洋个人博客

浙ICP备17051806号-1

浙ICP备17051806号-1

还没有评论,来说两句吧...